nº 1.005 - 27 de marzo de 2024

nº 1.005 - 27 de marzo de 2024

Parlamento Europeo

La Eurocámara da luz verde a una ley histórica para regular la Inteligencia Artificial

El Parlamento Europeo aprobó el pasado 13 de marzo el Reglamento Europeo de Inteligencia artificial (AIA, por Artificial Intelligence Act), que tiene por objetivo regular los usos de la Inteligencia Artificial para limitar los riesgos que de ellos se derivan. Lo más significativo del Reglamento es su enfoque en la clasificación de los sistemas de IA según el nivel de riesgo que presentan. Esta estrategia permite una regulación más precisa y eficaz, con robustos estándares de seguridad y defensa de los derechos fundamentales. Estos estándares serán cruciales para prevenir el uso de la IA en aplicaciones que podrían ser represivas, manipulativas, intrusivas o discriminatorias.

Según informó la Eurocámara, el Reglamento aún está sujeto a una última comprobación jurídica-lingüística. Su aprobación definitiva (mediante el llamado procedimiento de corrección de errores) está prevista para antes del final de la legislatura. La ley también debe ser adoptada formalmente por el Consejo.

Entrará en vigor veinte días después de su publicación en el Diario Oficial y será de plena aplicación veinticuatro meses después de su entrada en vigor, con excepción de: las prohibiciones de prácticas (se aplicarán seis meses después de la fecha de entrada en vigor); los códigos de buenas prácticas (nueve meses después); las normas sobre la IA de uso general, incluida la gobernanza (doce meses después), y las obligaciones para los sistemas de alto riesgo (treinta y seis meses después).

Ámbito de aplicación: se extiende a proveedores de sistemas de IA que se pongan en servicio o comercialicen dentro de la UE o cuya salida se utilice en la UE, independientemente de su origen; y a usuarios de los mismos, considerando usuarios a quienes explotan esos sistemas, y no a los afectados.

No es aplicable a: autoridades públicas de terceros países ni a organizaciones internacionales cuando unos utilicen sistemas IA en el ámbito de la cooperación policial o judicial con la UE o sus EEMM. Tampoco se aplica a los sistemas de uso militar o utilizados en el contexto de la seguridad nacional, ni a los utilizados con el solo propósito de la investigación y el desarrollo científico.

El Reglamento define Sistema de Inteligencia Artificial como aquel que opera con elementos de autonomía y que, basándose en datos y entradas obtenidos de humanos o máquinas, infiere como alcanzar unos objetivos propuestos, usando para ello técnicas basadas en el aprendizaje-máquina o en lógica y conocimiento, y genera como salida contenidos, predicciones, recomendaciones o decisiones que influyen en el entorno con el que el sistema interactúa.

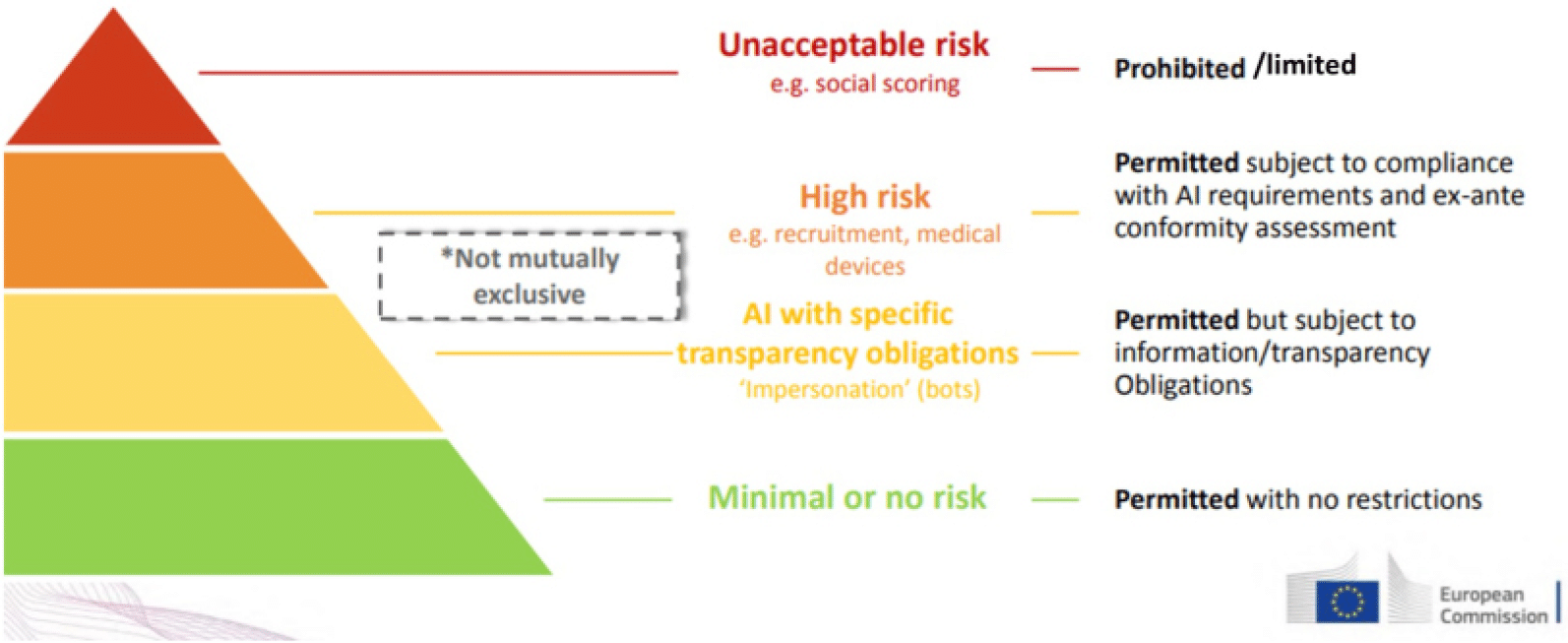

El Reglamento establece una jerarquía de riesgos en función del uso de la IA y sobre las categorías detectadas, establece una serie de obligaciones.

Categorización de los niveles de riesgo

1. Riesgo inaceptable: Esta categoría incluye aquellos sistemas de IA que representan una amenaza directa a la seguridad pública, los derechos fundamentales o la privacidad. Su uso está estrictamente prohibido, salvo en situaciones muy excepcionales.

2. Alto Riesgo: Aquí se clasifican los sistemas de IA que podrían tener un impacto considerable en los derechos fundamentales de los individuos por su relación con servicios y procesos que afectan a la salud, la seguridad, el empleo, etc. Su uso está permitido siempre que se cumpla con ciertas salvaguardas adicionales y se monitorice su funcionamiento.

3. Bajo Riesgo o riesgo inexistente: Finalmente, los sistemas que no se ajustan a las categorías anteriores se consideran de bajo riesgo. Es importante destacar que esta clasificación no es explícita, sino más bien por exclusión. En esta categoría prima la capacidad de decisión de los ciudadanos de forma libre, informada, voluntaria e inequívoca para el uso de estas tecnologías. Algunos sistemas se incluyen en esta categoría de riesgo bajo (por ejemplo, los sistemas de IA generativa, chatbots, etc.) con algunas obligaciones concretas de transparencia.

Sistemas de alto riesgo

El Reglamento dedica gran parte de su articulado a regular los sistemas de alto riesgo, que divide en dos grandes grupos:

Por un lado, mediante un análisis de riesgos se ha identificado un conjunto de familias de sistemas de IA que pueden considerarse de alto riesgo si su salida es relevante respecto a una acción o decisión que pueda presentar un riesgo a la salud, la seguridad o los derechos fundamentales. El Reglamento enumera y describe este conjunto, que incluye, entre otros, sistemas de identificación biométrica, de protección de infraestructuras críticas, de selección y promoción de personal, de utilización en fronteras, o los usados por las Fuerzas y Cuerpos de Seguridad del Estado o la Administración de Justicia. La Comisión puede actualizar esta lista mediante un acto delegado.

Por otro lado, existen productos que ya están regulados por normativa armonizada de la UE, y que bajo esa normativa están sujetos a evaluación de conformidad. Hay un conjunto limitado de familias de estos productos, que incluye entre otros los dispositivos médicos, los trenes o la maquinaria. Un sistema IA que constituya uno de estos productos, o constituya un componente de seguridad de uno de estos productos, estará sujeto a su correspondiente normativa armonizada.

Obligaciones para los sistemas de alto riesgo

Así, se prevén obligaciones claras para estos sistemas de IA de alto riesgo (debido a que, como se ha adelantado, pueden ser muy perjudiciales para la salud, la seguridad, los derechos fundamentales, el medio ambiente, la democracia y el Estado de derecho). Algunos ejemplos de usos de alto riesgo de la IA son las infraestructuras críticas, la educación y la formación profesional, el empleo, los servicios públicos y privados esenciales (por ejemplo, la sanidad o la banca), determinados sistemas de las fuerzas de seguridad, la migración y la gestión aduanera, la justicia y los procesos democráticos (como influir en las elecciones). Estos sistemas deben evaluar y reducir los riesgos, mantener registros de uso, ser transparentes y precisos y contar con supervisión humana. Los ciudadanos y ciudadanas tendrán derecho a presentar reclamaciones sobre los sistemas de IA y a recibir explicaciones sobre las decisiones basadas en ellos que afecten a sus derechos.

Requisitos de transparencia

Los sistemas de IA de uso general y los modelos en los que se basan deben cumplir ciertos requisitos de transparencia, respetar la legislación de la UE sobre derechos de autor y publicar resúmenes detallados del contenido usado para entrenar sus modelos. Los modelos más potentes que podrían plantear riesgos sistémicos deberán cumplir requisitos adicionales, como realizar evaluaciones de los modelos, analizar y mitigar los riesgos sistémicos e informar sobre los incidentes.

Además, las imágenes, contenidos de audio o de vídeo artificiales o manipulados («ultrafalsificaciones») deberán etiquetarse claramente como tales.

Entidades de supervisión

Existirán al menos una autoridad nacional notificante y al menos una autoridad de supervisión de mercado como autoridades nacionales competentes para los propósitos del Reglamento. Las autoridades de supervisión de mercado monitorizarán el correcto funcionamiento, ya en mercado, de sistemas de IA de alto riesgo, identificando riesgos sobrevenidos, incidentes u otras situaciones que exijan tomar medidas sobre los sistemas de IA de alto riesgo.

En el esquema de certificación de productos que propone el Reglamento, una autoridad notificante habilita a organismos de evaluación de conformidad para hacer las evaluaciones de conformidad en materia de IA a productos que quieran comercializar o poner en funcionamiento los proveedores. Los sistemas de IA regulados por su propia normativa (segundo grupo de los antes descritos) estarán supervisados por la autoridad de supervisión designada en esa normativa. Para el caso de sistemas de identificación biométrica utilizados para fuerzas y cuerpos de seguridad del estado, migración y administración de justicia, las autoridades de supervisión serán, o bien las autoridades nacionales de supervisar las actividades de seguridad, migración y asilo, o bien la agencia de protección de datos.

A nivel europeo, se constituirá un Comité Europeo de Inteligencia Artificial, donde participará un representante de cada Estado miembro. El Comité orientará sobre la implementación del reglamento, elaborará guías y establecerá las reglas básicas para elaborar sandboxes. ■